Die Computermaus hatten im Reich der Computer lange Zeit das Sagen. Mit dem Vormarsch mobiler und per Sprachbefehl gesteuerter Geräte nähert sich diese Phase ihrem Ende. Praktisch ganz verschwunden ist mittlerweile jene mechanische Kugel, die die Revolution ins Rollen brachte. Betrachtungen über eine Erfindung und zwei Männer, die Geschichte schrieben.

Bereits zu Beginn der 60er-Jahre vertrat der Radartechniker, Ingenieur und Erfinder Douglas (Doug) C. Engelbart die Auffassung, dass das Sitzen vor dem Bildschirm eines Tages zum Standard für Kopfarbeiter und der Computer zum Werkzeug der Wahl beim Erarbeiten und Teilen von Wissen werden würde. Wie so viele Visionäre lachte man ihn damals aus. Zum Glück verzichtete er auf den Arztbesuch – Helmut Schmidt hat bekanntlich einmal empfohlen, bei Visionen so zu verfahren – und verfolgte stattdessen ein bahnbrechendes Projekt.

Dank Informatik-Pionier Alan Kay weiß man, dass sich die Zukunft am besten voraussagen lässt, indem man sie erfindet. So hielt es wohl auch Engelbart, denn seine Pionierarbeit im Bereich Mensch-Maschine-Interaktion am „Augmentation Research Center“ des „Stanford Research Institute“ gipfelte am 17. November 1970 im Erhalt des Patents für die Computermaus. Allerdings vergingen bis zum ersten kommerziellen Exemplar elf weitere Jahre. Für ihren Siegeszug als universelles Eingabegerät fehlte nämlich ein entscheidendes Detail: eine grafische Benutzeroberfläche.

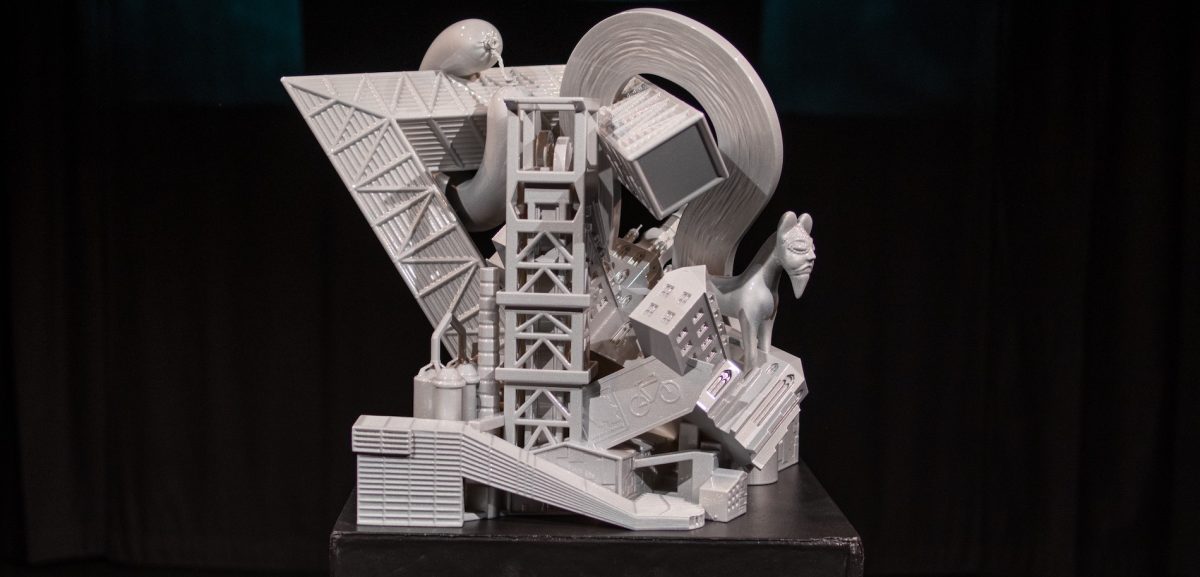

Die Telefunken-Computermaus

Die Steuerung von Computern mit einer Kugel war an sich nicht neu. 1946 wurde für die Luftraumüberwachung des britischen Militärs ein „Ball Tracker“ erfunden, aber zunächst geheim gehalten. Zwanzig Jahre dauerte es, bis die amerikanische Firma „Orbit Instrument Corporation“ den „X-Y Ball Tracker“ herausbrachte, der fest in Kontrolltische verbaut wurde. Mit der Maus stellte man später das Grundprinzip quasi auf den Kopf.

Bemerkenswert ist, dass die Computermaus gleich zweimal erfunden wurde. Rund ein Jahrzehnt bevor sie in den USA zum ersten Mal über die Ladentheke rollte, war sie optionaler Bestandteil deutscher „Telefunken“-Computersysteme. Hierbei diente sie der Vereinfachung vektorgrafischer Darstellungen. Mittels einer Bildschirmmarke wurden jeweils zwei Punkte bestimmt, die durch eine Linie verbunden werden sollten. Das notwendige permanente Umschalten zwischen Maus und Tastatur ist aus heutiger Sicht denkbar umständlich.

Verpasste Chancen

Anders als Engelbart hielten die Techniker bei Telefunken ihre „Rollkugel“ genannte Konstruktion, die im Oktober 1968 – zwei Monate vor Engelbart – publiziert wurde, für zu unbedeutend, um sie zum Patent anzumelden. Vielleicht deshalb, weil die Verbesserung der Bedienbarkeit nicht im Vordergrund stand. Man wollte Kunden in erster Linie ersparen, Löcher für Eingabegeräte in Tische bohren zu müssen.

Gelegentlich wird behauptet, dass das Erfinden eine deutsche Spezialität sei, wohingegen man sich in den USA darauf verstehe, aus einer Idee ein einträgliches Geschäft zu machen. Eine Ausnahme von der vermeintlichen Regel bildet die „Xerox Corporation“. Hier verpasste man in den 1970er-Jahren die einmalige Chance, für Jahrzehnte die Führung in der Computerindustrie zu übernehmen. Unter Mitwirkung von Mitgliedern aus Doug Engelbarts ursprünglichem Forscherteam hatte man im firmeneigenen „Palo Alto Research Center“ (PARC) 1973 mit dem „Xerox Alto“ – ohne es zu ahnen – das Vorbild aller heutigen PCs entwickelt. Engelbarts Maus war hier erstmals um eine grafische Benutzerobefläche mit Bildschirmfenstern ergänzt worden.

Vom Alto über Lisa zum Mac

Auf den jungen Steve Jobs, der nach Inspiration für den Nachfolger des Apple II suchte, machte der Alto, den er 1979 bei einem Besuch im PARC im Tauch gegen Apple-Aktienoptionen in Augenschein nehmen durfte, einen nachhaltigen Eindruck. Ihm blieb es auch vorbehalten, dem per Maus gesteuerten Computer zum Durchbruch zu verhelfen – während jenes Unternehmen, das mit der Vorstellung des ersten automatischen Kopiergerätes im Jahre 1959 womöglich sein Quantum an technologischen Revolutionen schon ausgeschöpft hatte, 1981 bei dem Versuch scheiterte, mit dem „Xerox Star“ ein kommerziell erfolgreiches Produkt auf Basis des Alto zu lancieren.

Jobs Coup gelang nicht auf Anhieb: Das Modell „Lisa“ von 1983 wurde trotz innovativer Bedienung und hoher Leistungsfähigkeit ein finanzieller Flop. Fast dreitausend Exemplare wurden später sogar in einer Mülldeponie vergraben, um sie steuerlich abschreiben zu können. Erst mit dem „Macintosh“ kam im Jahr darauf der Erfolg. Er ließ sich aufgrund geringerer Leistung und eines demzufolge niedrigeren Preises leichter vermarkten und verfügte dennoch über all die inzwischen unverzichtbaren Merkmale wie beispielsweise Papierkorb oder Undo-Funktion. Verglichen mit den vorherrschenden, aufwendig einzustudierenden Tastaturbefehlen war das ein riesiger Sprung nach vorn. Ähnlich wie der von der Schreibmaschine zur elektronischen Textverarbeitung.

Experimentelle Eingabegeräte

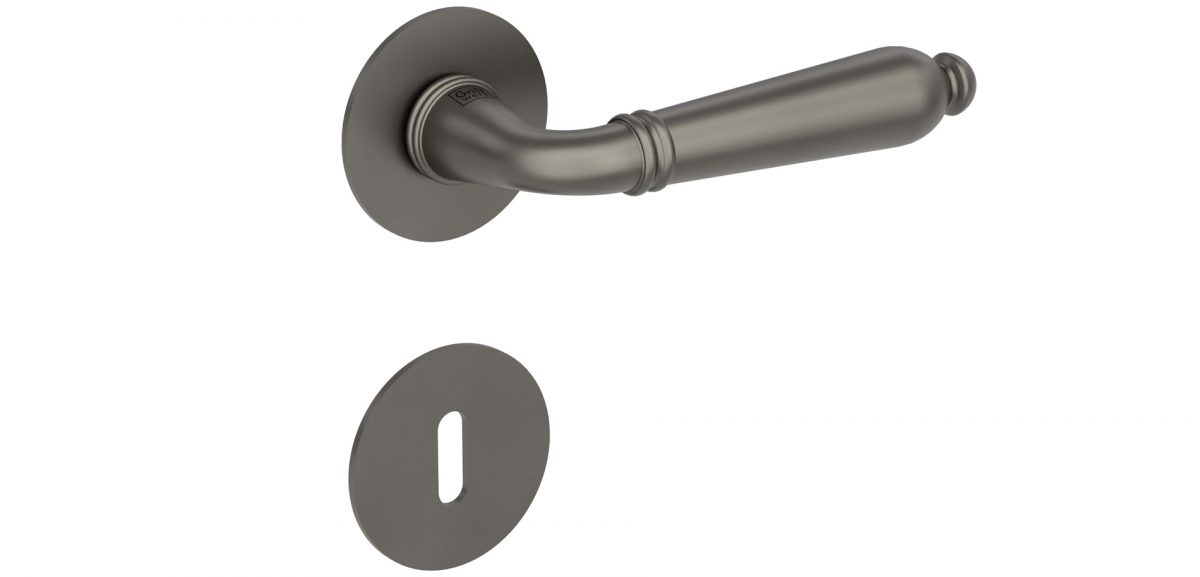

Eine wichtige Voraussetzung für das Reüssieren des Macintosh war die Vereinfachung der technisch komplexen Computermaus. Für den glücklosen Xerox Star hatte sie inklusive Schnittstelle mehr als ein vollständiges Computersystem unserer Tage gekostet. Durch die Verringerung der Zahl der benötigten Komponenten konnte Jobs den Preis gemeinsam mit einer Firma namens „Hovey-Kelley Design“ (später IDEO) auf einen Preis von 25 US-Dollar pro Einheit drücken. Da für die Vorläufer moderner CAD-Systeme die finanziellen Mittel nicht ausreichten, griffen die Entwickler hierfür ganz klassisch zu Stift und Papier.

Die Öffentlichkeit rezipierte die ersten Mäuse zwar zunächst als experimentelle Eingabegeräte, das unmittelbare Manipulieren von grafischen Objekten auf dem Bildschirm erwies sich jedoch schnell als das überlegene Bedienkonzept.

Das Vermächtnis

Für das herausragende Talent von Steve Jobs, Trends zu antizipieren und darauf aufbauend bahnbrechende Produkte von Weltgeltung zu kreieren, ist der Macintosh bezeichnenderweise nur einer von vielen Beweisen. Dabei liegt sein Vermächtnis nur vordergründig in spezifischen Geräten. Genau wie Engelbart hat Jobs sich unentwegt Gedanken darüber gemacht, wie die Benutzung von Computern zu einer natürlichen und intuitiven Angelegenheit werden kann. Überlegungen, die schließlich am 4. Oktober 2011, einen Tag vor Jobs Tod, in den Eintritt in die Königsdisziplin der Mensch-Maschine-Interaktion mündeten. An diesem Tag stellte Apple den Sprachassistenten „Siri“ vor.

Indem Wegbereiter wie Jobs und Engelbart dazu beitrugen, aus sperrigen, für Spezialisten konzipierten Kisten etwas zu machen, das uns rund um die Uhr begleitet, legten sie zugleich den Grundstein zu dem, was wir heute Digitalisierung nennen. Diese sorgt in unübersehbarer Weise dafür, dass sich neben unseren Werkzeugen auch unsere Art zu arbeiten und zu denken ändert – so wie Engelbart es einst gefordert hat.

Auch vor diesem Hintergrund wird die Ausnahmestellung von Steve Jobs deutlich. In der naiven Überzeugung, damit Neuland zu betreten, jongliert man heutzutage in inflationärer Weise mit Begriffen wie „Disruption“, „Kultur des Scheiterns“ oder „fail fast, fail better“. Für Steve Jobs war die permanente Infragestellung des Status quo keine hohle Phrase, sondern der rote Faden, der sein gesamtes Leben durchzog.